通常,大部分的情况下大家都不会使用Robots.txt来阻拦搜索引擎抓取我们网站,除非你确定这个页面对SEO有不良影响,如果你确定这些页面会影响SEO,并且你不希望搜索引擎来抓取,你就可以使用Robots.txt(比方说网站正在开发中,网站还没有完全做好)

使用Robots.txt文件很简单,你只需创建一个文件名为robots.txt,并且上传到网站根目录,在这个文件内写上你不希望搜索引擎抓取的页面链接。

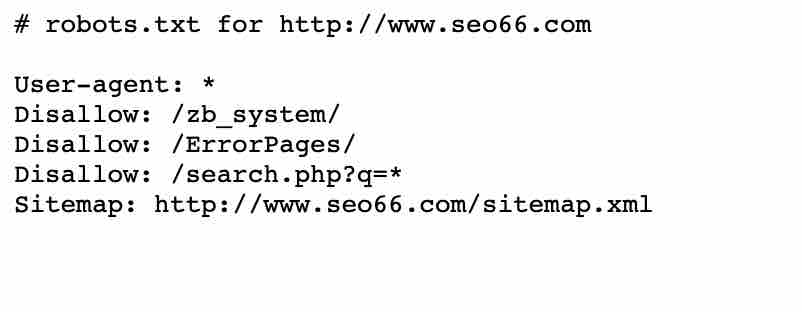

如下图,你能在www.seo66.com网站上看到,我也上传了这一个文件,而且我不希望搜索引擎抓取到我后台的登入页面,所以才会出现Disallow:/zb_system/这些内容

Robots.txt文件到底应该怎么写?

基本上Robots.txt会用到以下几个参数:

1、User-agent:填入搜索引擎蜘蛛的值(*号代表全部),主要定义下面的规则对那些搜索引擎生效。

常用的搜索引擎蜘蛛的值有:Googlebot(谷歌)、Baiduspider(百度)、Yahoo-slurp(雅虎)、Sogou spider(搜狗)、360Spide(360),如果没有其它特殊要求直接用*号即可。

2、Disallow:指定哪些目录或文件类型不想被抓取,需要指明路径,否则将会被忽略。

Disallow应该不能算是不抓取参数,因为如果是Disallow:(那么就是允许抓取所有内容),如果是Disallow: /(那么就是不允许抓取所有内容),如果填Disallow: /seo66/(则是不允许抓取seo66目录的所有内容)。不知道大家能否看懂,等下给大家举几个例子。

3、Allow:指定哪些目录或文件类型可以被抓取,需要指名路径,否则将会被忽略。

一般很少会用到这个,如果填Allow: /seo66/(那么就是允许抓取seo66目录的所有内容)。

如果您有一个需要禁止抓取的目录,但希望抓取该目录中的一个目录,就可以用如下代码(允许抓取seoziyuan目录里的seo,禁止抓取seoziyuan):

User-agent:*

Allow:/seoziyuan/seo/

Disallow:/seoziyuan/

4、Sitemap:指定网站内的Sitemap地图放置的位置,需使用绝对路径,如本站案例。

Sitemap: http://www.seo66.com/sitemap.xml

可以不用填写,如果有网站地图的最好加上

Robots.txt文件上的通配符和结束符

1 、通配符(*)

主流的搜索引擎基本都支持通配符和结束符。通配符会存在一部分未知的页面,所以使用时需要注意。例如:

Disallow:/html/*/66

*(星号)表示“匹配任何文本”,上述指令表示:阻止抓取以下所有地址:

http://example.com/html/aa/66

http://example.com/html/bb/66

http://example.com/html/cc/66

http://example.com/html/.../66

小心!以上还将阻止以下链接(可能不是您想要的):

http://example.com/html/aa/bb/cc/66

http://example.com/html/dd/ee/66

2、结束符($)

在指令最后加入“$”。比如,如果你想屏蔽所有以.php结尾的链接,那么你的可以设置成这样:

User-agent: *

Disallow: /*.php$

在这个例子中,搜索引擎无法抓取任何以.php结尾的链接,意味着搜索引擎无法抓取/index.php,但是搜索引擎可以抓取这个 /index.php?id=1450347,因为它没有以“.php”结尾。

Robots.txt举例

1、允许所有搜索引擎抓取任何部分

User-agent: *

Disallow:

2、禁止所有搜索引擎抓取任何部分

User-agent: *

Disallow: /

3、不允许百度抓取zb_system目录

User-agent: Baiduspider

Disallow: /zb_system/

4、禁止抓取/html/目录下的所有以“.htm”为后缀的链接。

User-agent: *

Disallow: /html/*.htm

5. 仅允许抓取以“.html”为后缀的链接。

User-agent: *

Allow: .html$

Disallow: /

6. 禁止抓取网站所有的动态页面

User-agent: *

Disallow: /*?*

7. 允许抓取jpg图片格式的文件,禁止抓取png图片格式的文件

User-agent:*

Allow .jpg$

Disallow: .png$

Robots.txt总结

Robots.txt相对来说还是比较简单的,特别要注意Disallow: 有无/(斜杠)。有斜杠和无斜杠相差甚远,这里大家一定要小心。

标签: Robots

评论列表

每天顶顶贴,一身轻松啊!http://npvrt.830x.cn/

2024年07月03日 00:06这里的资源非常丰富,帮助我解决了很多问题。http://www.gxmlm.com/

2024年07月04日 20:02坚持回帖!http://9qf.huichengyu.com/

2024年07月04日 20:07论坛的人气不行了!http://2khw0c.pvcabs.cn/

2024年07月04日 20:08论坛的帖子越来越有深度了!http://wap.gdlasa.com/

2024年07月04日 20:10缺乏激情了!http://id.zjchuzhou.com/

2024年07月04日 20:27这个帖子好无聊啊!http://mhjc3.yl-pump.com/

2024年07月04日 20:29这个帖子好无聊啊!http://2de51.zhijian.me/

2024年07月04日 20:29今天怎么了,什么人都出来了!http://hp1g.uropants.com/

2024年07月04日 20:53楼主该去看心理医生了!http://vtb6p.yl-pump.com/

2024年07月04日 20:58楼上的说的很多!http://xtsmfo.yl-pump.com/

2024年07月04日 20:58